Es ist Frühling in Berlin und es scheint eine gute Entscheidung zu sein, mal wieder die Hauptstadt zu erleben. Doch nicht der Berliner Frühling sondern Fragestellungen mit Bezug auf Big Data und Gedöns sollen Thema dieses Blogbeitrags werden. Gedöns ist ein eher negativ besetzter Alltagsbegriff, der gerne als Abwehrargument verwendet wird, wenn ein Gesprächspartner anscheinend Unwichtiges nicht recht einzuschätzen weiß. Genau so schwammig ist der Begriff Big Data auch, aber niemand hat bisher den Globaltrend Digitalisierung mit Unwichtigem in Verbindung gebracht.

Alljährlich veranstaltet die Tageszeitung taz in Berlin einen Kongress, der diesmal (25.4.2015) unter das Motto Gedöns gestellt wurde. Die Verwendung dieses Begriffs ist natürlich subtile Ironie, was man auch daran erkennen kann, dass der Duden unter Gedöns

- Getue, Aufheben

- für den alltäglichen Gebrauch nicht unbedingt notwendige und deshalb als überflüssig erachtete Gegenstände (Zitatende)

einstuft. Die Initiatoren von der taz verweisen zur Begründung dieser ironischen Titelwahl auf den ehemaligen Bundeskanzler Gerhard Schröder, dem einmal die genaue Bezeichnung des Familienministeriums nicht einfiel, was ihm dann dazu motivierte, die dort zu bearbeitenden Aufgabenstellungen als Gedöns einzuordnen.

Ob die Kongress-Bezeichnung Gedöns geschickt oder ungeschickt gewählt wurde, sei dahingestellt. Von Vorteil ist zweifellos, dass man unter Gedöns alle möglichen disparaten Trends und Themen packen kann, um ein Gespräch in Gang zu setzen, dass zu neuen Einschätzungen und Einsichten führt. Der Nachteil könnte aber sein, dass wichtige Themen nicht angemessen eingeschätzt werden, wenn sie unter das Gedöns-Label gepackt werden.

Von Gedöns zu Big Data

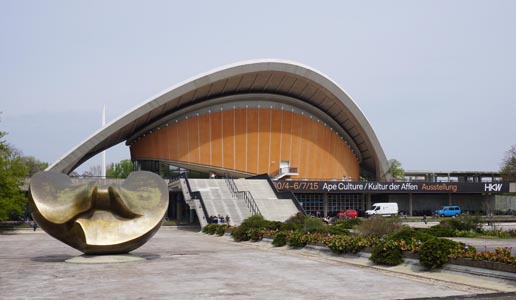

Mich persönlich hat das Thema Big Data am meisten am Gedöns-Kongress interessiert und die entsprechende Diskussions-Veranstaltung war bereits für 9 Uhr morgens im Zelt 2 angesetzt, was frühes Erscheinen verlangte, schließlich muss jeder Interessent sich vorher noch anmelden oder bei einer Tasse Kaffee einen Chor zur Einstimmung erleben. Die Stimmung war aber bei den Frühaufstehern gut, weil wunderbares Frühlingswetter einen milden Wind von der nahen Spree dem Kongresszentrum (heute Haus der Kulturen der Welt) zuführte.

Big Horror Data

Tatsächlich war Zelt 2 fast voll, als Moderatoren und Referenten um 9 Uhr pünktlich eintrafen. Die Podiumsdiskussion mit Yvonne Hofstetter und Christoph Kucklick (externe Referenten) und den taz-Mitarbeitern Jan Feddersen und Kai Schlieter war als Chance-Oder-Gefahr-Gespräch angelegt, was Sinn macht, denn Hofstetter und Kucklick vertreten kontroverse Sichtweisen, wenn es um Big Data geht. Hofstetter war für den Part Gefahren vorgesehen, von Kucklick ist bekannt, dass er auch viele positive Impulse bei Big Data sieht.

Das Aufeinandertreffen unterschiedlicher Sichtweisen zu Big Data war für mich der Grund, zum Gedöns-Kongress zu fahren, denn selten hat man die Chance, unterschiedliche Sichtweisen zum globalen Digitalisierungstrend gegeneinander gestellt zu sehen. Nicht nur in Deutschland sind zwar beide Sichtweisen auf Big Data wortgewaltig in getrennten Diskussionswelten vertreten (beispielsweise durch den verstorbenen FAZ-Herausgeber Frank Schirrmacher oder den bekannten Philosophen und Wissenschaftstheoretiker Klaus Mainzer). Wobei die prominesten Promotoren für Big Data und Künstliche Intelligenz (KI) eher aus dem englischsprachigen Raum kommen. Bekannt ist hier beispielsweise Ray Kurzweil, der über kurz oder lang die Abschaffung des Menschen durch KI für eine angemessene Sichtweise hält.

Der Veranstaltungstext auf der taz-Website hebt darauf ab, dass gegenwärtig mit Big Data und KI eine neue „beispiellose“ technologische Revolution stattfinde. Denn die Menschen und ihre Gewohnheiten würden auf neue Art durch Algorithmen erfasst und durchschaubar gemacht. Yvonne Hofstetter habe sich hier als Kritikerin profiliert, während Christoph Kucklick eher die Möglichkeiten betone, die durch die neuen technischen Trends genutzt werden könnten.

Big Harmonie?

Bereits bei der Vorstellungsrunde wurde aber deutlich, dass für die kurze Diskussion von 90 Minuten keine große Kontroverse zu erwarten ist. Jan Feddersen ließ durchblicken, dass er angesichts seines Lebenserfahrung nicht recht dran glauben könnte, dass man alle paar Jahre mal wieder eine revolutionäre Phase durch technische Neuentwicklungen erleben würde. Im weiteren Verlauf des Gesprächs kam dann auch keine rechte Streitmotivation auf, denn beide externen Referenten waren sich über die zugrundeliegenden Fakten weitgehend einig: Immer mehr Daten von Menschen und ihrer Computer-Nutzung (Smartphone, Internet-Verhalten) werden immer genauer erfasst und immer komplexer und konsequenter ausgewertet. Ob und wie dies verändernd für Mensch und Gesellschaft wirken werde, sei gegenwärtig noch nicht abschließend erkennbar. Es stellten sich zwar neue Anforderungen für Gesellschaft, Wirtschaft und die Individuen, doch ob und wie diese bewältigt werden, kann nicht so genau gesagt werden. Woraus dann aus meiner Sicht gefolgert werden kann, dass es gegenwärtig (noch) keine ausreichende Basis gibt, um zu einer fundierten Einschätzung hinsichtlich Big Data und KI zu kommen.

Kontroverse um die Erklärungskraft von Globalmodellen

Etwas kontroverser wurde die Frage diskutiert, ob uns Big Data in eine Gesellschaft der totalen Kontrolle führt. Kucklick wies darauf hin, dass es ein Widerspruch ist, wenn man einerseits von einer Totalkontrolle ausgeht, andererseits aber kritisiert, dass die Systeme nicht ausreichend differenziert genug sind, um angemessen auf menschliche Verhaltensweisen reagieren zu können, sodass sogar die Gefahr des Systemkollapses bestehe. Mir fällt dazu allerdings jetzt das Beispiel der Atomenergie ein, deren weltweiter Siegeszug immer noch nicht gestoppt ist, obwohl jedem hinreichend klar sein sollte, dass diese (wie viele andere Groß-Technologien) nicht wirklich beherrschbar sind. Woran liegt es, dass Menschen frohgemut Systeme einsetzen, obwohl sie deren Effekte und Konstruktionsprinzipien nicht wirklich verstehen können? An der Börse lassen die Händler inzwischen die Korken knallen, wenn ihre Computersoftware für den Hochfrequenzhandel mal wieder überraschend Erfolg gehabt hat. Was werden sie wohl tun, wenn eines Tages mal gänzlich andere Ergebnisse eintreten?

Sichtweisen auf die Welt der Daten

Trotz enttäuschender Harmonie zwischen Referenten, Moderatoren und Publikum würde ich trotzdem die Veranstaltung als hilfreich einstufen, weil das Sprechen über Big Data aus unterschiedlichen Perspektiven mir zu neuen Einsichten verholfen hat. Leider gibt es keinen Podcast der Veranstaltung, um hier die Fakten und Argumente der Diskussionsteilnehmer umfassend zu erschließen. Aus meinen eher kursorischen Aufzeichnungen kann ich aber einige interessante und neue Aspekte dem Big-Data-Thema abgewinnen.

Algo-Wettbewerbs-Märkte, asymmetrische Überwachung und Algorithmiker

Händler mit Aktien und anderen Wertpapieren, die an der Börse im Wettbewerb zueinander stehen, machen die Erfahrung, dass es unterschiedliche Qualitäten von Software gibt, wenn sie ihre Handelserfolge verbessern wollen. Es gibt also unterschiedlich gut funktionierende Strategien, um auf der Basis gleicher Daten zu erfolgreichen Verhaltensweisen zu kommen. Daraus folgt dann, dass um die besten Programme und die besten Programmierer ein harter Kampf geführt wird, der sich auch an den horrenden Preisen für Firmenaufkäufe (z.B. beim Facebook-Kauf von Start-Ups) ablesen lässt. Aus diesen Hinweisen von Yvonne Hofstetter wird aber deutlich, dass die Basis von künstlicher Intelligenz immer noch die natürliche Intelligenz ist. Denn der hohe Preis eines innovativen Unternehmens ergibt sich überwiegend aus der Handlungskompetenz der Entwickler.

Die These von der asymmetrischen Überwachung durch Big Data(Hofstetter) ist nicht so trivial, wie sie zunächst erscheint: Die Betroffenen von Big Data (Verbraucher, Arbeitnehmer, Staatsbürger) verfügen nicht über die gleichen Möglichkeiten, Transparenz über die Ergebnisse und die verantwortlichen Entscheider zu bekommen. Doch bedeutet nicht fehlende Transparenz in Bezug auf das Verhalten der Entscheider, dass auch den Computer-Algorithmen wichtige Daten fehlen? Big Data könnte allein deshalb nicht zur Herrschaft der Computer-Logik führen, weil die bisher Herrschenden sich der Transparenz durch Algorithmen entziehen können.

Bekannt ist ein ähnliches Phänomen aus der Industrie-Soziologie. Findet eine Untersuchung heraus, dass es besser für Rationalisierungsprozesse ist, wenn man mehr Handlungskompetenz an untere Einheiten überträgt, dann sperren sich Entscheidungsträger, weil sie damit ihre Machtpotentiale reduziert sehen. Die Logik der Rationalisierung wird begrenzt durch die strukturelle Irrationalität der Entscheidungsabläufe. Computer-Logik und Logik der Rationalisierung beruhen auf den gleichen Prinzipien. So begrenzt die Weigerung der Entscheidungsträger sich überwachen lassen, die Möglichkeiten der Computer-Algorithmen, die Zukunft besser vorauszusagen.

Kucklick schlägt vor, mittels eines neuen Berufsstands die Transparenz gegenüber der Computerlogik zu verbessern: Algorithmiker sollen in Zukunft (wie Wirtschaftsprüfer) dafür bezahlt werden, dass sie für die Öffentlichkeit die Angemessenheit und Fairness der Algorithmen unabhängig prüfen können. Allerdings stellt sich dann die Frage, wie man Fairness definieren sollte. Hofstetter sieht das noch globaler: Zwar könne man moralische Regeln in Computersoftware implementieren, doch es sei dann immer noch die Frage zu stellen, welche Moral zugrundegelegt werden muss. Schließlich operiert KI- und Big-Data-Software global, Moral sei aber regional sehr unterschiedlich strukturiert.

Mensch-Maschine-Unschärfe und Überraschung

Behandelt man Menschen so, wie Computer die Welt sehen, dann entsteht ein Problem. Menschen verhalten sich selten gemäß einem strukturierten Programm, wo gemäß genau festgelegten Eingabewerten bestimmte Abfolgen und bestimmte Handlungsergebnisse impliziert sind. Diese Unschärfe muss bei Big Data verschwinden, denn Computer haben damit Erfolg, dass sie Komplexität reduzieren. Wendet man Computer-Logik auf menschliches Verhalten an, dann entsteht also eine mehr oder weniger starke Unangemessenheit. Kucklick will dem nicht widersprechen, hält aber Hofstetters Bezug auf Kant für überzogen. Kants kategorischer Imperativ ist in dem Zusammenhang mit Big Data interessant, weil Kant annimmt, dass Menschen eine besondere Form von Handlungskompetenz inhärent ist, die nicht auf einzelnen Handlungserfordernissen, sondern auf übergeordneten Prinzipien fußt. Wir können nicht in jedem Einfallfall von vornherein wissen, was die richtige Handlungsweise ist, wir müssen sie im Einzelfall aus den übergeordneten Prinzipien ableiten. Das tun zwar Computer-Algorithmen auch, doch deren Vorgehensweise beim Ableiten ist bereits so konkret festgelegt, dass ihre Ergebnisse mit deterministischer Konsequenz feststehen.

Hofstetter beruft sich auch auf den Computer-Kritiker Joseph Weizenbaum, der bereits recht früh gegen Daniel Dennets KI-Apologie Position bezogen hatte. Gemeint ist wohl Dennets These „Wir müssen uns befreien von unserer Ehrfurcht vor dem Leben, wenn wir mit der künstlichen Intelligenz Fortschritte machen wollen“ (Joseph Weizenbaum, Absurde Pläne: Zeitmagazin vom 16.3.1990). Da passt es ganz gut, wenn Kucklick Intelligenz als „die Fähigkeit zu überraschen“ bestimmt. Da Computer schwer mit Überraschungen klar kommen können (ein singuläres Ereignis wie der Kollaps einer systemrelevanten Bank kann nicht detailgenau vorausgesehen werden), kann man sich der Kontrolle der Algorithmen nur noch mit überraschendem Verhalten entziehen. Doch diese Anforderung ist zugleich auch eine Überforderung, meint Kucklick. Für die Menschen der Zukunft komme es eher darauf an, dass sie in Kooperation mit Maschinen ihr Leben besser organisieren können.

Die Börse als Handlungsfeld für Big Data

Hofstetter entwickelt in ihrem Unternehmen nach eigenen Aussagen auch Software für Börsenentscheidungen, die selbstlernend ist. Konkret heißt dies, dass die Software Erfolgs-Muster erkennt und in ihre Börsenentscheidungen einfließen lässt. Interessant sei in diesem Zusammenhang, dass aber alle Handlungsmuster und Daten, die vor 2008 (Finanzkrise) angefallen sind, „in die Tonne gehören“, denn inzwischen hätten sich nicht nur die Regeln, sondern auch das Verständnis von sinnvollem Investment verändert. Es gebe gegenwärtig noch keine Konzepte, um hier Vorsorge für zukünftige Krisen zu treffen. Hier wurde aus dem Publikum der Vorschlag gemacht, dass eine Finanztransaktionssteuer weiterhelfen könnte, was aber als „andere Baustelle“ eingeordnet wurde.

Doch der Hinweis aus dem Publikum ist treffend. Würde man eine sehr niedrige Finanztransaktionssteuer einführen, dann wäre der Hochfrequenzhandel sofort vorbei, weil es sich nicht mehr lohnen würde, in Bruchteilen von Sekunden zu verkaufen und zu kaufen, denn der sehr kleine Gewinn würde vollständig oder weitgehend von der Transaktionssteuer weggefressen. Solche Entscheidungen werden schließlich nur deshalb an Computer-Software übertragen, weil Menschen nicht ausreichend Zeit haben, um innerhalb einer Sekunde dasselbe Papier zu kaufen und zu verkaufen, nur um sehr kleine Gewinne zu bekommen.

Allerdings ist der Verweis auf die Finanzkrise sehr wichtig, um hier eine bessere Einschätzung zu Big Data zu gewinnen. Wenn singuläre Ereignisse (wie der Kollaps einer einzelnen Bank) bisherige Daten und Zusammenhänge wertlos machen, dann sollte man sich schon fragen, ob man es verantworten kann, Finanztransaktionsentscheidungen von Computern vornehmen zu lassen. Hofstetter deutete an, dass auch die Börsenaufsicht Big-Data-Software einsetzt, um zukünftige Fehlentscheidungen der Systeme durch rechtzeitiges Abschalten der anderen Systeme zu begegnen. Das passt dann ganz gut zum Thema Überraschung. Allerdings müssten dann die Computer-Algorithmen der Überwachung der Hochfrequenz-Algorithmen nicht nur besser sein als diese, sondern auch mit Überraschung klarkommen können, worin eigentlich nicht ihre Stärke (wie oben skizziert) liegen kann.

Hofstetter: Digital bedeutet immer auch Rückkopplung

Hofstetter war für mich in ihren Thesen deutlich überraschender als Kucklick, der sich sicher bewusst darüber war, dass beim Gedöns-Kongress der taz keine Big-Data-Fans zu erwarten sind. Allerdings bringt er in seinem Buch zur granularen Gesellschaft viele Beispiele, die die These untermauern können, dass bei der Digitalisierung von Abläufen Rückkopplungsprozesse entstehen, die sich zunächst einer Planung entziehen.

Das Thema der Rückkopplung wird bei Big-Data-Befürwortern und auch bei Big-Data-Kritikern oft nicht ausreichend weit behandelt. So wird beispielsweise behauptet, dass die Polizei mit „predictive Analytics“ schon vorher wüsste, wo in Zukunft Verbrechen und Verbrecher auftreten werden. Wenn dem so sein sollte, dann werden sich sicher die Verbrecher um eine Verbesserung ihrer Erkenntnismöglichkeiten bemühen und sich dort nicht aufhalten, wo die Wahrscheinlichkeit eines Polizisten höher ist. Ihr Verhalten wird also sich mehr um Überraschung im Sinne Kucklicks bemühen müssen.

Denkbar ist es für mich daher auch, dass organisierte Verbrecher ihrerseits Big-Data-Algorithmen einsetzen, um die Häufigkeit, Raum und Zeit von Polizeikontrollen bestimmen zu können. Es wäre nicht das erste Mal, dass auch hier ein „algorithmischer Rüstungswettlauf“ beobachtet werden kann. Bekannt ist, dass Google und die Freude der Suchmaschinen-Optimierung heftig um die besten Vorgehensweisen zur Erkennung der Wünsche der Suchmaschinennutzer bemüht sind. Digitale Rüstungswettläufe gibt es auch an der Börse, wenn Algorithmen Entscheidungs-Logiken erkennen wollen, die andere Algorithmen versteckt anwenden.

Fazit: Wie kommen wir mit Big Horror Data klar?

Von den Moderatoren wurde am Ende der Veranstaltung versucht, eine positive Perspektive abzufragen. Könnte es nicht auch Big Data als Open-Source-Software geben und wie kommt man in Europa zu einer Unabhängigkeit von amerikanischen Konzernen, die gegenwärtig bei der Digitalisierung die Nase vorn haben? Man war sich weitgehend einig darüber, dass dafür viel Geld und ein hohes Maß von Expertise notwendig sind. Sozialer Widerstand gegen Big Data, eigentlich eine Voraussetzung um Geld und Expertise zu aktivieren, wäre aber gegenwärtig kaum zu spüren. Ziele für die nächste Zeit müssten sein:

- Bewusstsein für das Problem der zunehmenden Digitalisierung schaffen

- der Grundrechtschutz bei der Internetnutzung verbessern

- die Transparenz der Algorithmen mit und ohne Experten verbessern

Diesem Fazit kann kaum widersprochen werden. Doch wo wären die Ansatzpunkt hier zu setzen – eher in der Politik oder eher in der Bildung? Vielleicht gibt die demnächst in Berlin stattfindende re:publica hier konkretere Hinweise.

Verwandte Artikel:

- Das kann der magische Editor von Google Photos

- Die Wende ins Offene beginnt, wenn du bereit bist, das Bestehende nicht nur negativ zu sehen

- KI, Nachdenken und ein Sauerländer

- Google Suche mit 100 Ergebnissen

- Zusammenfassung von Text mithilfe von DeepL

- Fact Checking – Dialog mit KI-Chatbot – Von der Idee zur Recherche

- Analog und digital