Analog und digital

Die digitale Kommunikation verfügt über eine komplexe und logische Syntax, entbehrt aber auf dem Gebiet der Beziehungen einer Semantik.

Computer verarbeiten keine Informationen sondern Daten.

Die analoge Welt und damit auch alle Formen sind kontinuierlich und damit unendlich. Information dagegen ist radikal endlich und schon deswegen viel besser beherrschbar.

Die Begriffe analog und digital sind zentral für die Informatik, aber auch bedeutsam für die menschliche Interaktion. Relevanz für Menschen kommt den Begriffen analog und digital auch zu, weil die Produkte der Informatik (die Computer bzw. Computeranordnungen, Hardware und Software, Netzwerke wie das Internet usw.) überwiegend oder fast ausschließlich als digitale Informationsverarbeitungssystem verstanden werden: „Computer können nur digitale Daten verarbeiten, doch die Welt und der Mensch sind analog.“ Diese kritische Aussage kann nur geprüft oder verstanden werden, wenn man die Begriffe analog und digital hinreichend genau definieren kann. Es soll im Folgenden versucht werden, analog und digital so zu definieren, dass man sowohl bei Geräten (Hardware) als auch bei Daten (Signalen, beobachtbaren physikalische oder sonstigen Größen) schnell erkennen kann, welches Objekt jeweils analog oder digital ist. Darauf aufbauend wird dann erläutert, warum angesichts der analogen Welt digitale Systeme wie Computer und Internet unvollkommene Werkzeuge bleiben müssen.

Worauf können die Begriffe analog und digital sinnvollerweise angewendet werden?

Analog und digital wird häufig im Zusammenhang mit den Begriffen Signal oder Datum (Singular von Daten) verwandt. Auch der Begriff der Information wird häufig mit dem Begriff digital bzw. analog verknüpft. Alle drei Begriffe (Signal, Datum, Information) nehmen implizit auf eine Weltsicht Bezug, bei der zwischen Objekten der Wirklichkeit und der Bedeutung, die diese Objekte für einen Beobachter haben, zu unterscheiden ist. Man muss die Welt interpretieren oder konstruieren, um aus der Vielzahl der möglichen Eindrücke Unterscheidungen treffen zu können, damit diese anschließend als Signal, Datum oder Information für weitere Bearbeitungs- oder Interpretationsprozesse genutzt werden können.

Digital-Uhren und Analog-Uhren als Beispiel

Häufiger verwandt und populär wurde das Begriffspaar analog und digital, als die ersten Digital-Uhren auf den Markt kamen, was ungefähr in den 1970er-Jahren des vorigen Jahrhunderts war. Zwar gab es schon Jahrhunderte davor Digital-Uhren, wie die Wikipedia zu Digital-Uhren zu berichten weiß, aber das waren seltene Einzelexemplare. Hier in den nächsten beiden Bildern findet man einen Vergleich von zwei Uhren, bei dem ich darauf geachtet habe, dass die Analog-Uhr möglichst wenige digitale Elemente (Zeichen oder Zahlen) enthält:

Analog-Uhr aus Wikipedia

Analog-Uhr aus Wikipedia https://en.wikipedia.org/wiki/File:Modern_clock_chris_kemps_01.svg (abgerufen am 14.09.2012)

Digitale Uhr aus der Wikipedia

Digital-Uhr aus Wikipedia https://de.wikipedia.org/wiki/Digitaluhr (abgerufen am 14.09.2012)

Nach einem naiven Verständnis von Realität bewegen sich die Zeiger dieser und vieler anderen analogen Uhren gleichmäßig um den Mittelpunkt der Uhr.[i]

Entscheidend bei der Analog-Uhr ist, dass man als Beobachter der vollständig funktionierenden Uhr immer (auch nach der Beobachtung) noch festlegen kann, welche unterschiedlichen Zustände der Uhr als relevant für die Unterschiedlichkeit genommen werden. Diese Möglichkeit der Festlegungen von Merkmalsausprägungen der Uhr (Uhrzeiten) ist potentiell beliebig erweiterbar. Mathematiker können sagen, dass die möglichen Zustände der analogen Uhr (die möglichen Uhrzeiten bei einer analogen Uhr) eine unendliche Mächtigkeit/Häufigkeit haben. Eine Digitaluhr kann hingegen stets nur endlich viele Zustände haben. Bei dem Beispiel der Digital-Uhr oben aus der Wikipedia sind es genau 1.440 Zustände: 24*60.

Definition digital

Verallgemeinert man dieses Beispiel, dann kommt man zu der Aussage: Digitale Signale, Informationen oder Daten können stets nur aus einer überschaubaren endlichen Menge möglicher Merkmalsausprägungen von einem Beobachter selektiert werden. Nachdem die Beobachtung erfolgt ist, können digitale Daten zwar weiter vergröbert, aber nicht weiter verfeinert werden.

Weil bei einem digitalen Merkmal die Anzahl der Merkmalsausprägungen nur endlich sein kann, macht es Sinn, den Begriff digital vor dem Begriff analog zu definieren, denn analog nimmt implizit Bezug auf eine potentielle Unendlichkeit möglicher Merkmalsausprägungen. Auch für die Definition von digital greife ich auf die Wikipedia zurück, denn diese definiert digital kurz und prägnant und auch auf eine Weise, dass man recht schnell den digitalen Charakter eines Signals, eines Datums oder einer Information bestimmen kann.

Digital (v. lat. digitus, „Finger“) bezeichnet

– „den Finger betreffend“, „mit dem Finger“

– wert- und zeitdiskrete Signale, siehe Digitalsignal

– die Anzeige eines Messinstrumentes (beispielsweise einer Uhr) mittels Ziffern

– kurz die Digital Equipment Corporation, einen ehemaligen Computerhersteller

Zitatende (https://de.wikipedia.org/wiki/Digital; abgerufen am 14.09.2012; Fettdruck von mir).

Der erste und der letzte Spiegelstrich von dieser Digital-Definition führen nicht direkt zum Ziel einer operationalen Definition von digital, aber die beiden anderen. Ein digitales System hat stets wert- oder zeitdiskrete Signale; die Menge der möglichen Signale ist endlich und überschaubar. Jeder menschliche Beobachter kann genau aufzählen, welche Zustände bei digitalen Signalen überhaupt möglich sind. Auch ist die Anzahl der möglichen Zustände exakt berechenbar. Die andere Definition für digital (3. Spiegelstich) kann noch einfacher genutzt werden. Die Anzeige des Messgeräts muss (wie bei der Digitaluhr) durch Ziffern erfolgen. Mit Ziffern sind hier wohl die Ziffern, die man bei Zahlen üblicherweise verwendet, gemeint. Ich sehe aber auch kein Problem bei dieser Definition von digital „Ziffern“ durch „Ziffern und Zeichen“ zu ergänzen. [ii]

Aus dieser Definition von digital ergibt sich eine interessante Schlussfolgerung:

Das herkömmlich Alltagsverständnis von digital und analog ist fehlerhaft

Nimmt man die oben skizzierte Definition von digital ernst, dann wird deutlich, dass viele digitale Daten aus dem Alltag gar nicht digital sind.

Beispiel Foto: Bei einem Foto kann man als Beobachter normalerweise nicht sagen, wie viel unterschiedliche Signale (Varianten dieses Fotos) möglich sind. Das Foto übermittelt den Gesamteindruck einer Situation, die einzelnen Bildpunkt werden hierfür nicht wahrgenommen, was durchaus der Absicht des Fotografen entspricht. Es mag Fotos geben, bei denen man noch einzelne Bildpunkte klar unterscheiden kann, bei der Masse des Fotos ist das nicht möglich und deshalb macht es auch keinen Sinn, bei einem normalen Foto zwischen digital und analog zu unterscheiden. Auch dazu ein einprägsames Beispiel:

Ist dies ein Digital-Foto?

Dies ist ein Digital-Foto.

(46*30 Bildpunkte, jeder Bildpunkt kann 216 verschiedene Web-Farbwerte annehmen. )

Beispiel Musik: Auch Musik ist selten digital, selbst wenn sie von einer CD kommt und auf einem Computer abgespielt wird. Man weiß, dass auf der CD nur Nullen und Einsen stehen, doch die kann man nicht in ihren Auswirkungen auf die Unterschiedlichkeit von Tönen oder Geräuschen hören, selbst wenn man ein perfektes Gehör hat. Womit auch klar wird, dass die „Digitalität einer Signalfolge“ nichts über die Qualität des Höreindrucks aussagen kann.

Vorgehen, wenn man eine digitale Signalquelle eindeutig als digital identifizieren möchte

Man muss sich die Signalquelle genau anschauen und sich überlegen, wie viele und welche unterschiedlichen einzelnen Signale man wahrnehmen kann oder wahrnehmen könnte. Ist diese Anzahl leicht berechenbar (und zwar durch Beobachtung der Quelle, nicht durch Nachschauen in der Dokumentation des Geräts) und kann man unterschiedliche Signale klar unterscheiden, dann ist die Signalquelle digital.

Man hat die Bestimmung von digital einfacher, wenn die Signale nur Bedeutung im Zusammenhang mit Zeichen Sinn ergeben, die auf der Signalquelle vorfindbar sind. Kann man diese Zeichen klar unterscheiden und ist deren Anzahl einfach zu bestimmen? Können die Zustände des Geräts, die Signale, auf eineindeutige Weise möglichen Zeichenfolgen zugeordnet werden? Dann liegt eine digitale Signalquelle vor.

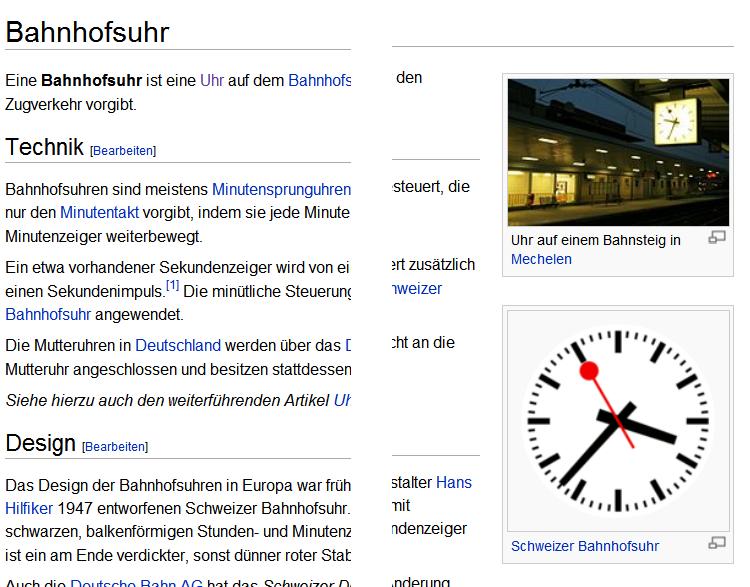

Anwendungsbeispiel Bahnhofsuhr: Ist dies eine Digital-Uhr?

Digitale und Analoge Bahnhofsuhr aus Wikipedia

Jeder kennt die Bahnhofsuhr. Auch hier wieder ein Bild aus der Wikipedia. Relevant für dieses Anwendungsbeispiel ist, dass die normale Bahnhofsuhr eine „Minutensprunguhr“ ist. Der Sekundenzeiger geht genau wie der Minutenzeiger nicht kontinuierlich im Kreis herum, sondern springt von Sekunde zu Sekunde. Bei zwölf Uhr hält der Minutenzeiger kurz inne, anschließend bewegen sich der Sekundenzeiger und der Minutenzeiger genau eine Position weiter.

Die Auflösung dieses Rätzels zu analog und digital finden Sie weiter unten in den Kommentaren.

Definition analog

Hier habe ich eine gute Definition nicht in der Wikipedia, sondern in einem älteren Lexikon der Informatik gefunden.

Zitat Seite 43

analog: kontinuierlich, stetig veränderbar. Eine Menge von Werten heißt analog, wenn sie einem Intervall der reellen Zahlengeraden entspricht. Der Begriff wird in der Datenverarbeitung meist als Gegensatz zu digital verwendet. Die Übertragung von Informationen erfolgt meist analog, also durch kontinuierliche Veränderungen von elektrischen Spannungen, von Lichtwellen oder Magnetisierungen. […]Zur Verarbeitung in Computern müssen analoge Werte digitalisiert werden, z. B. wenn Aufnahmen einer Kamera, Drehgeschwindigkeiten von Motoren oder Eingaben von Sensoren zu bearbeiten sind (Analog-digital-Umsetzung).

Zitatende (Fettdruck und Kürzungen von mir)

Quellenangabe: Duden Informatik A-Z. Fachlexikon für Studium, Ausbildung und Beruf von Dr. Volker Claus und Dr. Andreas Schwill.

Die Autoren hätten es sich einfacher machen können, wenn Sie auf die Unendlichkeit Bezug genommen hätten. Indirekt haben Sie das, denn ein „Intervall der reellen Zahlengerade“ enthält unendlich viele Punkte bzw. repräsentiert potentiell beliebig viele Werte. Möglicherweise haben sie den Bezug auf die Unendlichkeit deshalb vermieden, weil es umstritten ist, ob des in der Wirklichkeit überhaupt Unendlichkeit gibt oder geben kann. Insbesondere die Quantentheorie hat gezeigt, dass jeder Veränderungsprozess nicht beliebig verfeinerbar ist. Irgendwann ist Ende mit der Verfeinerung, dann die Kontinuität in Diskontinuität über. Für praktische Beobachtungsprozesse ist diese Schranke aber wenig relevant. Ein Messgerät zeigt Zeigerausschläge auf einer Skala an, deren Unterteilung für praktische Zwecke beliebig verfeinerbar ist.

Der Beobachter ist relevant für die Unterscheidung von analog und digital

Es liegt am Beobachter, wie er mit dieser Verfeinerungsmöglichkeit umgeht. Liefert das Messgerät keine analogen sondern digitale Daten, dann können diese nicht weiter verfeinert werden. Hier gibt es eher das umgekehrte Problem: Wie kann man mit den sehr stark verfeinerten Daten umgehen, sodass man mit einer geringeren Datenmenge die annähernd gleiche Information bekommt? In der digitalen Bildbearbeitung wird dies mit dem JPEG-Verfahren umgesetzt, aus der Audio-Datenverarbeitung kennt man das MP3-Verfahren der Datenmengen-Verkleinerung digitaler Daten. Für analoge Daten sind solche Vergröberungen nur möglich, wenn die analogen Daten zunächst in digitale Daten transformiert werden.

Die Beschränktheit des digitalen Beobachters Computer

Man weiß bisher recht wenig über die Datenverarbeitung des Menschen mittels seines Gehirns. Die Datenverarbeitung dort ist auf jeden Fall ziemlich anders als die Datenverarbeitung, die man bei Computern herstellen kann. Es spricht ziemlich viel dafür, dass diese Datenverarbeitung des Gehirns, wenn sie nicht sowieso analog ist, nicht auf digitale Abläufe reduziert werden kann. Wenn dem so ist, dann kann man aber bei bisher vorfindlichen Computern eine Schranke der Datenverarbeitung und der Erkenntnisfähigkeit festmachen: Computer arbeiten digital, können nur digitale Daten verarbeiten und sind somit auf eine relativ kleine Endlichkeit der Welt beschränkt.

Meines Erachtens korrespondiert diese Beschränkung im Digitalen mit einer anderen Beschränkung, die mit dem Gegensatzpaar Sinn versus Sinnfreiheit beschrieben werden kann. Wenn ein menschlicher Beobachter Fotos betrachtet oder Sound hört, dann sieht er keine Pixel und hört auch keine einzelnen Töne. Er nimmt einen Gesamteindruck wahr, bzw. konstruiert diesen entsprechend des Sinns den er dem gegenwärtigen Ereignis im Bewusstsein seiner Biografie zuordnet.

Das können Computer zum gegenwärtigen Zeitpunkt noch nicht und es ist auch nicht absehbar, dass sich dies bald ändert. Auch zur digitalen Bildbearbeitung braucht man immer noch ein Werkzeug, was ohne Computer auskommen muss. Ich kann dem Computer die Anweisung geben, die Helligkeit oder den Kontrast des Bildes zu verändern, doch der Beobachter muss darüber entscheiden, was denn für eine Aussage mit dem neu entstehenden Bild verbunden ist. Dies verdeutlicht die Aussage zu Beginn: „Der Mensch und die Welt sind analog, Computer sind auf digitale Prozesse angewiesen.“ Der Sinn, den menschliche Beobachter sich und der beobachtbaren Welt zuordnen, liegt nicht im Digitalen, sondern im Analogen, das zwischen oder über den digitalen Daten zur Geltung kommt.

Weil die Welt analog ist, kann sie nicht in einem digitalen System angemessen repräsentiert werden.

Anmerkungen zum Artikel

[i] Dieses Verständnis ist deshalb naiv, weil man mit Hilfe der Physik der Elementarobjekte zeigen kann, dass es in Wirklichkeit keine kontinuierlichen oder gleichmäßigen Bewegungen geben kann: Quantelung der Welt. Doch diese Quantelung hat normalerweise keine Relevanz. Um den Begriff analog zu bestimmen, muss man auf die Berücksichtigung der Quantelung der Welt verzichten, weil man sonst auf die Verwendung des Begriffs analog verzichten müsste.

[ii] Schließlich kann man in der Informatik sehr einfach zeigen, dass jedes Zeichen auf Ziffern eineindeutig abbildbar ist. Für Computer reichen ja auch Zeichenketten aus, die lediglich zwei Zustände annehmen können; Stichwort Digitalisierung.)